【서울 = 서울뉴스통신】 최정인 기자 = 마이크로소프트가 첫 번째 로보틱스 모델 ‘로-알파(Rho-alpha, ρα)’를 공개하며 피지컬 AI 시장 진출을 본격화했다. 자연어 명령을 이해해 로봇의 양손 조작까지 가능하게 하는 것이 핵심으로, 반복 작업 중심의 기존 산업용 로봇을 넘어 비구조화된 환경에서 인간과 협업하는 로봇 구현을 목표로 한다.

마이크로소프트 리서치는 22일 자사의 소형언어모델(SLM) ‘파이(Phi)’ 시리즈를 기반으로 한 시각언어모델(VLA)을 적용해 로-알파를 개발했다고 밝혔다. VLA를 통해 로봇은 시각·언어 정보를 결합해 환경을 인지하고 추론하며 행동할 수 있다. 로-알파는 자연어 지시를 정교한 제어 신호로 변환해 양손 조작을 수행하며, 기존 VLA의 인지·학습 범위를 확장한 ‘VLA+’ 모델로 차별화된다는 설명이다.

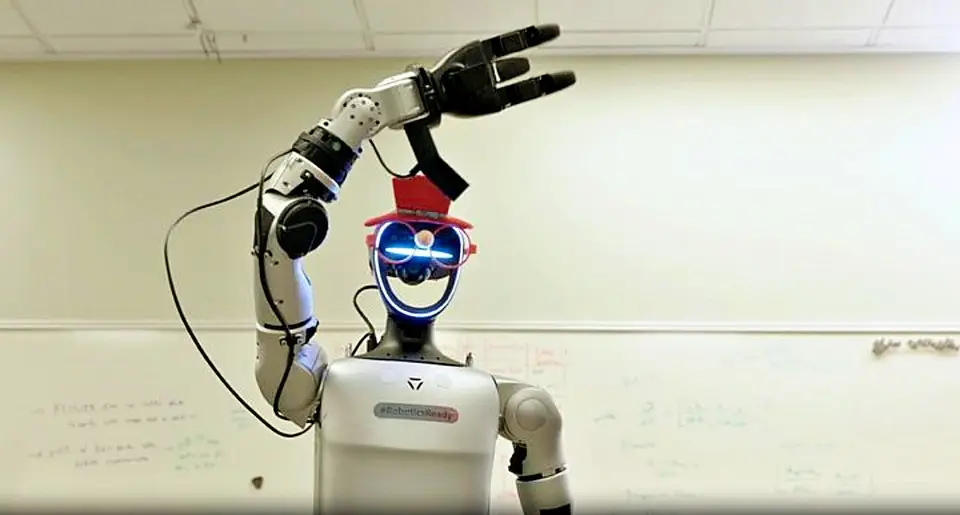

마이크로소프트는 듀얼 암 시스템과 휴머노이드 로봇을 대상으로 양손 조작 성능을 높이기 위한 최적화 작업에 착수했다. 특히 촉각 센싱을 새롭게 접목해 시각·언어 이해에 촉각 인지를 결합했다. 실제 로봇 궤적 데이터와 시뮬레이션 학습을 병행해 데이터가 부족한 촉각 영역을 보완하는 방식이다. 이를 위해 엔비디아의 로봇 시뮬레이션 플랫폼 아이작 심을 활용해 합성 데이터를 생성하고, 실제 시연 데이터셋과 결합해 학습 효율을 높였다.

로-알파는 현장 사용자의 피드백을 지속적으로 학습하도록 설계됐다. 사용자는 3D 마우스 등 직관적인 장치로 로봇 동작을 즉시 보정할 수 있으며, 시스템 작동 중에도 피드백을 반영해 성능을 개선한다. 마이크로소프트는 로-알파 도입을 원하는 고객사를 대상으로 리서치 얼리 액세스 프로그램을 운영 중이며, “역동적인 상황과 인간의 선호에 기민하게 적응하는 로봇이 일상과 업무 환경에서 더 높은 효용을 제공할 것”이라고 밝혔다.